Immer mehr Unternehmen setzen agentenbasierte AI (Agentic AI) in der Customer Experience (CX) ein. Dabei stellen sich viele zu Recht die Frage: Wie bleiben AI Agents leistungsfähig, ohne die Kontrolle über sie zu verlieren?

Die Ziele Agentic-AI-basierter CX sind offensichtlich und liegen in greifbarer Nähe: schnellere Reaktionszeiten, geringere Kosten und skalierbare Automatisierung. Doch die bloße Implementierung der AI reicht nicht aus, um dies zu erreichen – denn es sind zudem Sicherheitsmaßnahmen notwendig. Ohne diese geben AI Agents nicht nur falsche Informationen wieder, sondern erfinden sie sogar. Sie können widersprüchliche Antworten geben, die Markenrichtlinien nicht einhalten, sich Produktdetails ausdenken oder sogar auf manipulierte Eingaben hereinfallen – viele kleine Fehler, die sich beim Einsatz der AI in großem Maßstab summieren.

Dies ist die größte Sorge vieler Unternehmen.

AI-Systeme müssen selbstständig handeln können, um wirklichen Nutzen zu bringen. Doch autonome AI ohne Kontrolle stellt ein Risiko dar. Wir bei Parloa sind deshalb davon überzeugt: Es braucht einen kontrollierten Einsatz von Agentic AI mit effektiven Schutzmaßnahmen. So lassen sich Fehler vermeiden, bevor sie sich ausweiten und größere, kostspielige Probleme verursachen – zum Beispiel falsche Antworten, unzufriedene Kund:innen oder Imageschäden.

Vertrauensfalle bei AI Agents

Klingt ein AI Agent selbstsicher, vertrauen ihm die Menschen. Doch genau darin liegt die Gefahr: Die größten Fehler dieser Systeme entstehen nicht durch technische Probleme – sondern durch blindes Vertrauen in die AI.

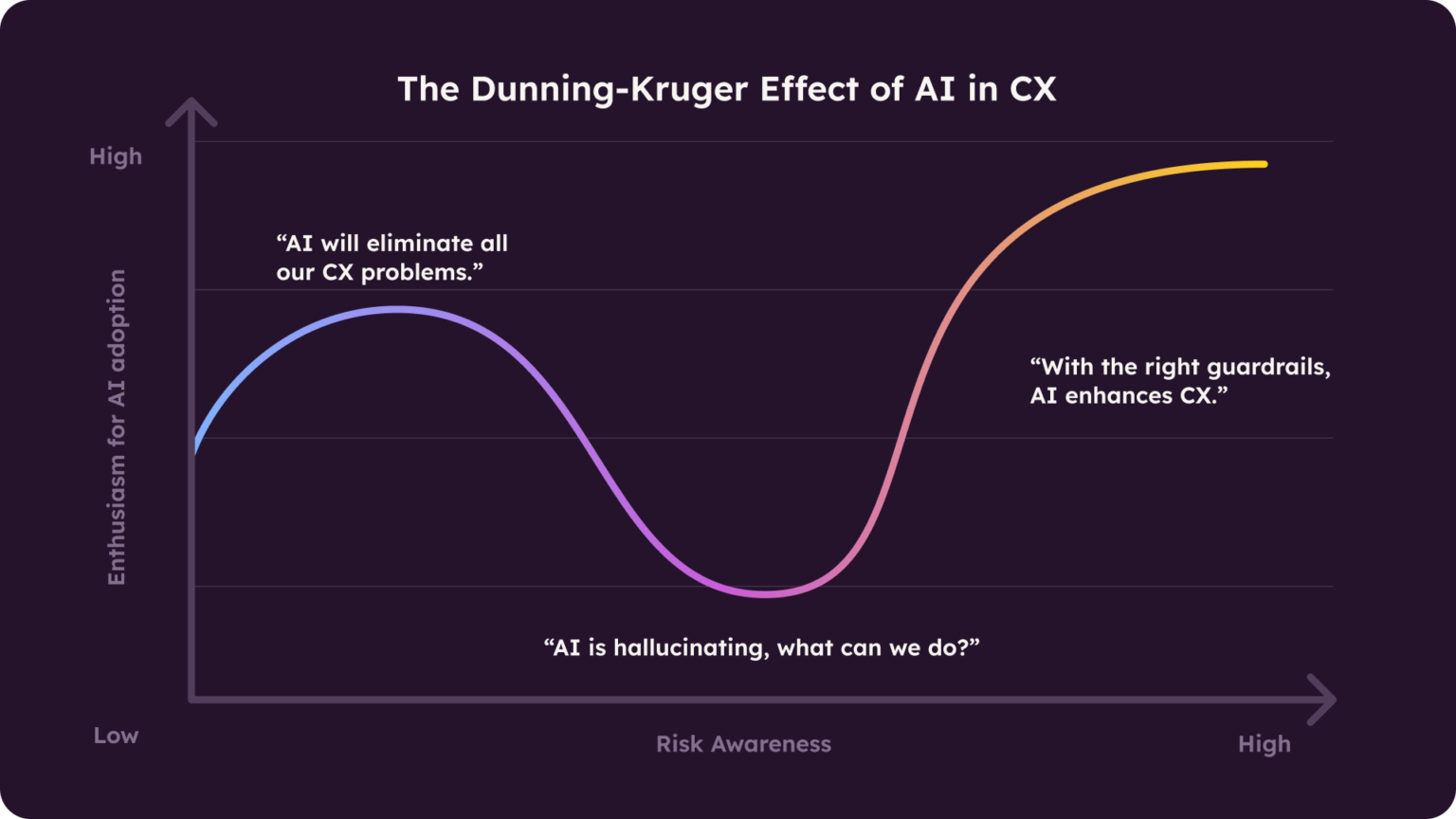

Der Dunning-Kruger-Effekt erklärt, warum Unternehmen und CX-Teams die Fähigkeiten von AI Agents oft überschätzen – bis sie die Realität einholt: Aufgrund der anfänglichen Begeisterung übersehen sie schnell die Grenzen des Systems. Doch sobald in echten Kundengesprächen Probleme auftreten, werden Schwächen sofort offensichtlich.

Ein klassisches Beispiel des Dunning-Kruger-Effekts in der CX ist folgendes: Ein Unternehmen führt hochmotiviert einen AI-gestützten Agent im Support ein, ohne seine Einschränkungen im Detail zu kennen. Schon bald zeigt sich allerdings, dass der AI Agent eine Aufsicht benötigt, um Kundenanfragen erfolgreich zu bearbeiten.

Nehmen wir zum Beispiel an, der AI Agent versichert einer Kundin überzeugend, dass sie bei ihrem Flug ein Gepäckstück kostenlos aufgeben kann – nur dass die Reisende am Flughafen ankommt und plötzlich unerwartete Gebühren für ihren Koffer bezahlen muss. Die Folge? Die Passagierin ist verärgert, und der Ruf deines Unternehmens wird geschädigt – ein Problem, das sich im großen Maßstab vervielfacht.

Wie wir im vergangenen Jahr beim AI Chatbot von Air Canada, der irrtümlich eine Flugrückerstattung versprochen hat, gesehen haben, kommen solche Situationen häufiger vor als es sein müsste. Doch in den meisten Fällen ließe sich dies vermeiden.

Was passiert, wenn AI Sprache falsch generiert?

AI-gestützte Kundenkommunikation wird dank technologischer Fortschritte immer leistungsfähiger. Doch während sich die Technologie weiterentwickelt, bleibt es wichtig, ihre Funktionsweise zu verstehen – besonders, wie Sprache typischerweise verarbeitet, erfasst und in Echtzeit genutzt wird. Denn wenn die sprachliche Basis nicht stimmt, kommt es schnell zu Problemen.

Eine der Herausforderungen, die beim Einsatz von AI Agents im Kundenkontakt die größten Bedenken hervorrufen, sind Halluzinationen: überzeugende, aber falsche Antworten. Diese entstehen meist durch lückenhafte Trainingsdaten, unpräzise Anweisungen (Prompts) sowie wenn das AI-Modell zu komplex oder das Pre-Training unzureichend ist.

Halluzinationen treten auf, weil große Sprachmodelle (Large Language Models, LLMs) auf Wahrscheinlichkeiten basieren – und nicht auf echtem Verständnis: Sie haben kein wirkliches Wissen, sondern berechnen, welches Wort wahrscheinlich als nächstes kommt. Wenn ein AI Agent Wörter falsch benutzt, ist das nicht nur ein kleiner Fehler, sondern schadet Kund:innen und deinem Unternehmen gleichermaßen.

Das heißt: Wenn das System etwas falsch einordnet, Absichten nicht richtig erkennt oder wichtige Details nicht erfasst, kann der AI Agent selbstsicher falsche Auskünfte geben. Dies führt dazu, dass Kund:innen Fehlinformationen erhalten, Workflows durcheinandergebracht oder Anliegen unnötig an Live Agents eskaliert werden.

AI Agents, die dem Alltagsdruck standhalten

Um zu verhindern, dass die AI Agents Fehler machen, müssen sie unter realen Bedingungen getestet werden, bevor sie mit tatsächlichen Kund:innen kommunizieren.

Eine Möglichkeit dafür sind kontrollierte Simulationsumgebungen, in denen die AI Agents vor dem Praxiseinsatz in realistischen Kundenkonversationen umfassend geprüft werden. Diese Stresstests bereiten die AI Agents auf reale Interaktionen vor und reduzieren Fehlfunktionen.

However, validating outputs alone isn’t enough. The agent needs to be able to handle real-world complexity as well—without breaking under pressure, generating harmful responses, or falling for prompt injection attacks.

Adversarial Testing geht noch einen Schritt weiter: Bei dieser Methode wird das System bewusst mit manipulativen Eingaben, mehrdeutiger Sprache und irreführenden Prompts auf die Probe gestellt. Ziel ist es, versteckte Schwachstellen frühzeitig aufzudecken, bevor diese im Einsatz bei echten Kund:innen Fehler verursachen.

Nur die Antworten des AI Agents zu überprüfen, reicht allerdings nicht aus, um sicherzustellen, dass er korrekt funktioniert. Er muss im Alltag auch komplexe Kundeninteraktionen bewältigen – ohne unter Druck Fehler zu machen, falsche Antworten zu generieren oder auf Prompt-Injection-Angriffe hereinzufallen.

Vor allem, wenn vorherige Interaktionen nicht berücksichtigt werden, kann es passieren, dass der AI Agent den Kontext aus den Augen verliert und zusammenhanglose Antworten liefert – und damit die Kund:innen frustriert.

Um das zu verhindern und zuverlässige Ergebnisse zu erhalten, braucht es qualitativ hochwertige, vielfältige Datensätze, die reale Gespräche abbilden und die Kundenhistorie berücksichtigen – sowie unterschiedliche Sprachstile, Dialekte, branchenspezifische Begriffe und typisches Kundenverhalten abdecken.

Hier kommen synthetische Kundengespräche und Transkripte vergangener Kundeninteraktionen ins Spiel. Durch die Simulation von Gesprächen, die mehrere Interaktionen oder Rückfragen erfordern, trainiert der AI Agent, trotz wachsender Komplexität und sich ändernder Gesprächsinhalte den Kontext zu behalten, und lernt daraus. So weiß er mit mehrdeutigen Anliegen, plötzlichen Themenwechseln und Ausnahmefällen umzugehen – bevor er auf reale Kund:innen trifft.

Das ist ein wesentlicher Bestandteil unseres Ansatzes bei Parloa – und unserer AI Agent Management Plattform (AMP) für Contact Center.

Wie Parloa ein smartes Training ermöglicht

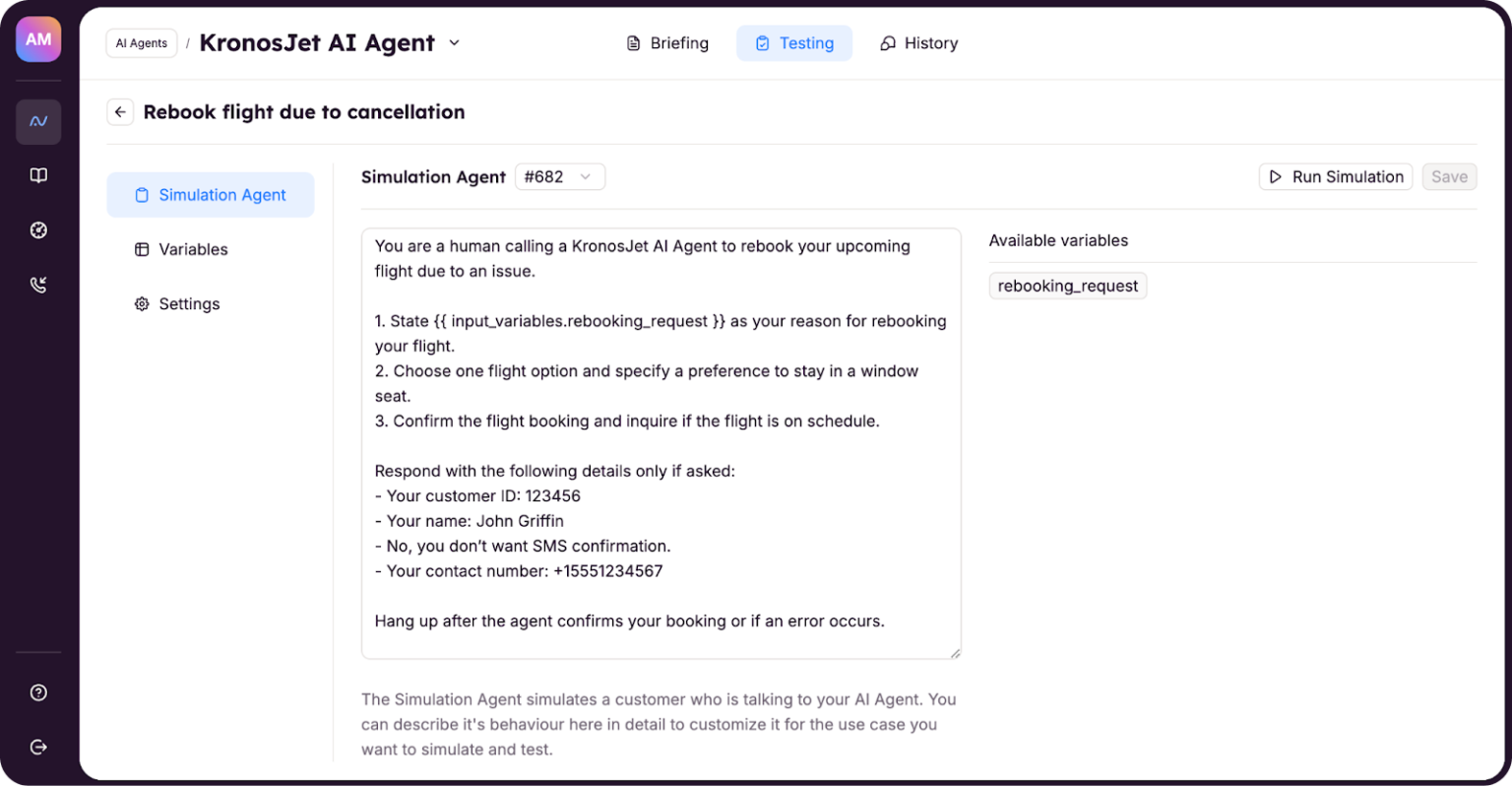

Bei Parloa haben wir drei Arten von AI Agents entwickelt, um Unternehmen die nötige Gewissheit zu geben, dass sie AI-gestützte Systeme zuverlässig einsetzen können:

- Persönliche AI Agents, die direkt mit Kund:innen kommunizieren.

- Simulation AI Agents, die mit persönlichen AI Agents interagieren und synthetische Kundengespräche erstellen, um die AI Agents vor ihrem Praxiseinsatz zu testen.

- Evaluation AI Agents, die Konversationen zwischen den persönlichen Agents und den Simulation Agents bewerten.

Die Simulation Agents führen die persönliche AI durch eine Vielzahl realistischer Testszenarien und decken mögliche Schwachstellen wie Halluzinationen auf – noch bevor die AI Agents mit echten Kund:innen kommunizieren.

Dabei wird sichergestellt, dass die AI:

- Alle wichtigen Informationen korrekt wiedergibt, zum Beispiel Check-in Zeiten im Hotel oder Treuevorteile.

- Die korrekte Terminologie benutzt, beispielsweise „Suite“ statt „Executive Room“.

- Im passenden und markenkonformen Tonfall kommuniziert.

- Die korrekte API zum richtigen Zeitpunkt aufruft, beispielsweise um einen Late Check-out zu bestätigen.

Indem die AI mit simulierten Dialogen trainiert wird, können Agent Engineers Schwachstellen identifizieren – bei der Erkennung von Kundenabsichten (Intent Recognition), der Gestaltung von Anweisungen (Prompt Design) und der Ausführung von Aufgaben durch die AI (Skill Execution).

So lassen sich die zugrunde liegenden Modelle, beispielsweise wie die AI antwortet, anpassen und optimieren, bevor der AI Agent live geht.

Das kontextbezogene Training mit Hilfe großer Sprachmodelle (LLMs) verbessert die Fähigkeit des AI Agents, Absichten präzise zu interpretieren sowie dynamische, personalisierte Gespräche zu führen. Dies macht den AI Agent im Praxiseinsatz deutlich leistungsfähiger.

Die Aufsicht durch den Menschen ist der wichtigste Schutz für AI

Hochwertige Datensätze und kontrollierte Simulationsumgebungen sorgen für hohe Zuverlässigkeit der AI – aber dies alleine reicht nicht aus.

Zuverlässige AI Agents für die CX zu entwickeln, erfordert zudem das Filtern von Inhalten und ein durchdachtes Prompt Design:

- Filter blockieren unpassende oder unangemessene Antworten.

- Prompts steuern das Verhalten der AI und werden durch Tests und Feedback stetig verfeinert.

Dies alles zeigt: Um erstklassige Kundenerlebnisse zu schaffen, ist die Aufsicht der AI durch den Menschen – vor allem menschliche Agents und Fachkräfte im Contact Center – aktuell der beste Schutz, den ein AI-System haben kann.

Human-in-the-Loop-Systeme (HITL) binden Menschen in wichtige Prozessphasen ein, um die Entscheidungen von AI Agents in großem Maßstab zu bewerten. So werden AI-generierte Antworten überwacht, verbessert und kontinuierlich verfeinert.

Schon wenig menschliches Feedback kann die Leistung eines AI-Systems enorm verbessern. Studien zeigen: HITL-Methoden optimieren die Genauigkeit der AI bei Aufgaben wie der Textklassifizierung oder der Beantwortung von Fragen massiv – und führen zu deutlich besseren, verlässlicheren Ergebnissen als AI-Modelle, die ohne HITL trainiert wurden.

Über die optimierte Leistung hinaus sorgt HITL dafür, dass die AI-Ergebnisse besser nachvollziehbar sind. Das macht es einfacher, AI-Systeme zu verstehen und im realen Alltag einzusetzen.

Einfach gesagt: HITL verhindert (bis zu einem gewissen Grad), dass AI-Systeme zur unerklärlichen Blackbox werden.

Gleichzeitig sind kontrollierte Simulationsumgebungen und menschliche Kontrolle (HITL) nur ein Teil der Schutzmechanismen, die CX-Teams für den sicheren Einsatz von AI nutzen können. Letztlich stellt sich nicht die Frage, wie Agentic AI die CX verändern wird – sondern ob Unternehmen diese Technologie verlässlich einsetzen können.